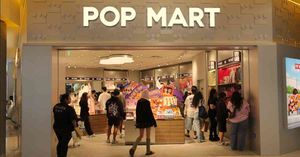

DeepSeek | FOCUS | DeepSeek-V3.2再革新,硬撼閉源算力躍進

02/12/2025

OpenAI旗下閉源大模型ChatGPT迎來3歲生日之際,中國「開源之神」DeepSeek周一(1日)傍晚發布兩款新模型「贈興」--DeepSeek-V3.2及DeepSeek-V3.2-Speciale,不僅完美展示思考有多快、推理有多深,且續維持令人驚嘆的成本效益,被視作開源大模型引領AI平權的又一里程碑。

GPT5用戶破8億,惟接連翻車

當ChatGPT的周活躍用戶突破8億,8月登場的旗艦模型GPT‑5卻接連翻車,包括將簡單方程「5.9 = X + 5.11」解作「X=-0.21」,把俄勒岡州(Oregon)標為「Onegon」……引發僅是GPT-4o「換皮」、實則毫無突破的猜疑。

8月登場的旗艦模型GPT‑5接連翻車。

不過,剛橫空出世的DeepSeek-V3.2,不僅正確解答「猴子有666根香蕉,每次最多背66根香蕉,可是猴子每走1米就要吃1根香蕉,問猴子最多能走多遠?」這樣的經典「燒腦」題,更問鼎全球首個斬獲2025年「頂尖四賽(國際奧數、中國奧數、國際大學生設計總決賽、國際信息學奧林匹克)」金牌的大模型。

「稀疏注意力」機制提升效率

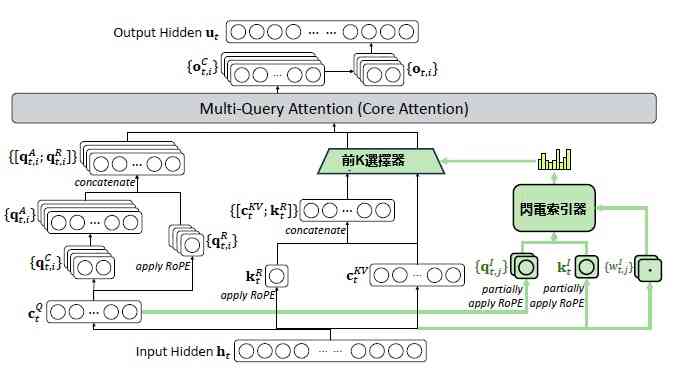

能答題或許不算特殊本領,畢竟谷歌旗下Gemini 3亦擅長跑分/屠榜,並獲數學家陶哲軒認證,以10分鐘解決百年數學難題(Erdosproblem/367)。今次V3.2的最大突破,當屬引入「DeepSeek 稀疏注意力(DSA)」機制,大幅提升處理長上下文的效率。

DeepSeek稀疏注意力(DSA)在MLA架構下的工作流程。

例如,試想像DSA是位圖書館館長,當讀者提出「通俗解釋量子糾纏」的查詢,其既不會讀完圖書館裏每一本書的每一頁,來搜尋「量子糾纏」這個關鍵詞,也不會死板地徑直前往擺放物理學分類的書架,而是融會貫通精選科學、人文、歷史等適配書籍,並深度處理如何「通俗」解釋。

此得益於V3.2配置的「閃電索引器(lightning indexer)」微型神經網絡,以及「細粒度選擇機制(fine-grained token selection mechanism)」,既大幅降低計算量,亦保持高準確率。

想得更深,成本僅為對手零頭

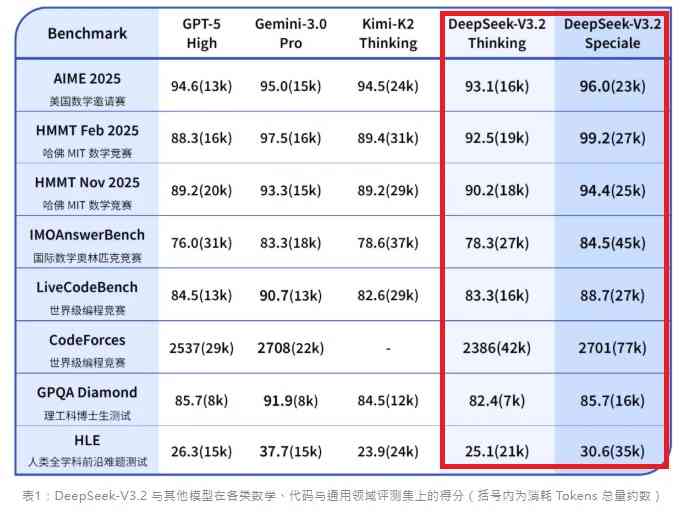

除了V3.2又快、又好、又省,同日推出的V3.2-Speciale更旨在探究延伸思考的潛力,在強化學習中移除長度懲罰(length penalty),並整合早前DeepSeekMath-V2的數據集和獎勵機制,允許猜想、試錯、修正、自我驗證,相當於模拟人類探索式的深度推理。此正正是其在國際奧數、哈佛MIT數學競賽等跑贏GPT-5 High和Gemini-3 Pro的原因,惟世界級編程競賽等推理任務仍略輸於Gemini-3。

DeepSeek-V3.2-Speciale在國際奧數、哈佛MIT數學競賽等跑贏GPT-5 High和Gemini-3 Pro。

按每百萬Token輸出計,GPT-5需10美元,而DeepSeek-V3.2及V3.2-Speciale僅為0.42美元,相當於前者的零頭,再次印證中國開源大模型能憑藉獨特架構和訓練範式,超越西方閉源大模型單純的算力、參數軍備競賽。

值得一提的是,DeepSeek僅將今次版本命名為V3.2(V3、V3.1分別為去年12月、今年8月發布),或意味就挑戰閉源模型的複雜任務(DeepSeek坦言,過去數個月,閉源模型和開源模型之間的效能差距正在擴大),V4將成扭轉戰局的關鍵一役,且拭目以待。

撰文:金子安

【香港好去處】2026去邊最好玩?etnet為你提供全港最齊盛事活動,所有資訊盡在掌握!► 即睇